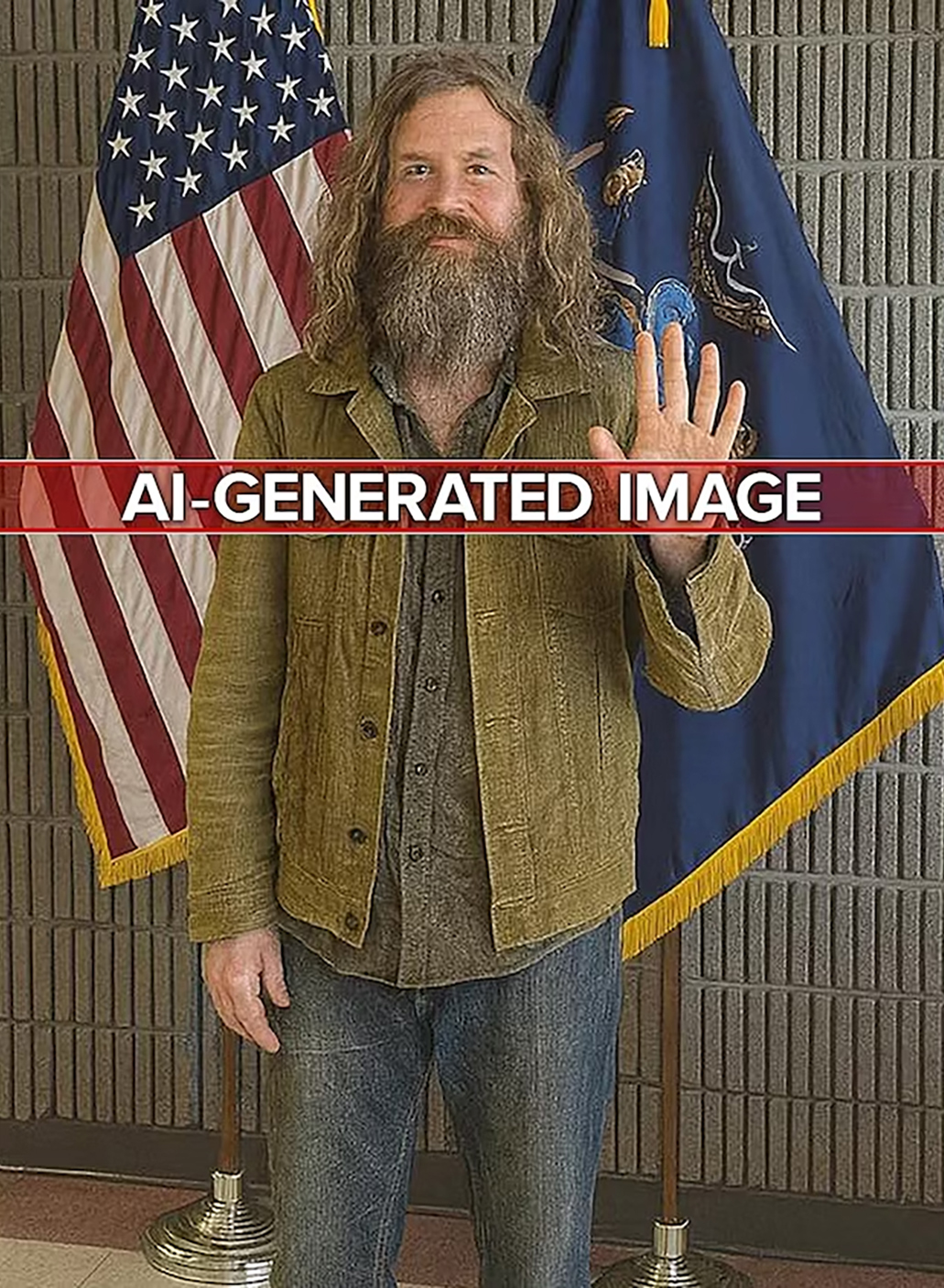

Slika neurednog, raščupanog starijeg čoveka proteklih nedelja je kružila internetom, najčešće dok stoji ispred vrata nečije kuće ili je već u samom stanu. Posle nekoliko prijava i intervencija policije, ispostavilo se da je fotografija čoveka – lažna, generisana veštačkom inteligencijom. Deca su upotrebom Snepčet AI alata kreirala slike čoveka u svom domu i potom ih slala roditeljima uz poruke da su ga pustili u kuću da koristi toalet, odspava ili samo popije vodu, navodeći da osoba tvrdi da poznaje roditelje sa posla ili fakulteta. Očekivano, usledile bi panične reakcije primalaca i hitni pozivi policiji. Snimci su objavljivani na mreži – zarad zabave i „lajkova“.

Tako je jedan TikTok- video, koji prikazuje uznemirenu majku kako moli svoju ćerku da pozove policiju nakon što je devojčica podelila slike mršavog muškarca koji stoji u njihovoj kuhinji i spava na kauču, pogledalo preko 65.000 korisnika. U drugom, sa skoro 900.000 pregleda, prestravljeni otac je pozvao sina 21 put nakon što je dečak podelio snimke muškarca sa bradom kako koristi očevu četkicu za zube i spava na njegovom krevetu. Policijska odeljenja u Mičigenu, Njujorku i Viskonsinu izdala su javna upozorenja da ovo nije bezazlena igra, već uznemiravanje i zloupotreba javnih službi, te da ovakva „šala“ dehumanizuje beskućnike i izaziva paniku. Dva maloletnika povezana sa ovim događajem privedena su na saslušanje u Sjedinjenim Državama, a slični događaji registrovani su i u Engleskoj.

Ovaj trend pokazao je koliko su se visokosofisticirani generativni alati veštačke inteligencije proširili, najavljujući budućnost u kojoj ne možete verovati čak ni slikama prijatelja i porodice, piše portal Futurism. Tu su i druga etička pitanja i implikacije po svakodnevni život. Ova viralna „šala“ podseća na to da svi kreatori i korisnici alata veštačke inteligencije moraju ono što proizvedu jasno označiti kao sintetičko ili manipulisano. Ako ne možemo verovati onome što vidimo i dobijamo čak i od prijatelja ili porodice, ukupno društveno poverenje se raspada.

Dodatno, kakve stereotipe ili štetu prema ranjivim grupama može promovisati sadržaj generisan veštačkom inteligencijom i da li bi trebalo da postoji dodatna kontrola sadržaja koji se dotiče marginalizovanih grupa? Ako neko koristi AI da bi napravio „šalu“ koja uključuje stereotipnu ili stigmatizovanu figuru, posledice nastupaju ne samo za one koji su bili meta podvale, već i za društvene stavove uopšte. Iako priča o viralnom „AI beskućniku“ deluje kao banalna šala tinejdžera, iz šire društvene i tehnološke perspektive posmatrano, ona je simptom dubljih procesa koji će imati dugoročne posledice.

Ovaj trend je rani signal jednog novog društvenog pejzaža u kome će AI moći da manipuliše percepcijom realnosti na svakodnevnom nivou. Ako se naviknemo da svakodnevno koristimo veštačku inteligenciju za kreiranje lažnih scena — „za šalu“, „za sadržaj“, „za pažnju“ — granica između stvarnog i izmišljenog postaće sve tanja, kultura u kojoj manipulisanje slikama, videima i informacijama postaje normalno i može nastati neka vrsta „zamora istinom“

Ovaj trend je rani signal jednog novog društvenog pejzaža u kome će AI moći da manipuliše percepcijom realnosti na svakodnevnom nivou. Ako se naviknemo da svakodnevno koristimo veštačku inteligenciju za kreiranje lažnih scena — „za šalu“, „za sadržaj“, „za pažnju“ — granica između stvarnog i izmišljenog postaće sve tanja, kultura u kojoj manipulisanje slikama, videima i informacijama postaje normalno i može nastati neka vrsta „zamora istinom“. Ničemu ne verujemo, jer sve može biti fabrikovano. Lažne uzbune i nepotrebno angažovanje hitnih službi može stvoriti priliku za simulaciju kriminalnih radnji ili terorističkih pretnji, sajber-sabotaže i dezinformacione kampanje. Konačno, „šale“ mogu prerasti u digitalno oružje, a ono što počinje kao TikTok trend može evoluirati u sofisticirani alat za političke i propagandne grupe koje dipfejk formate upotrebljavaju za diskreditaciju političkih protivnika, podsticanje etničke mržnje i društvenu manipulaciju.